1. AIがWeb設計をどう再定義したか

レスポンス設計の前提が崩れた

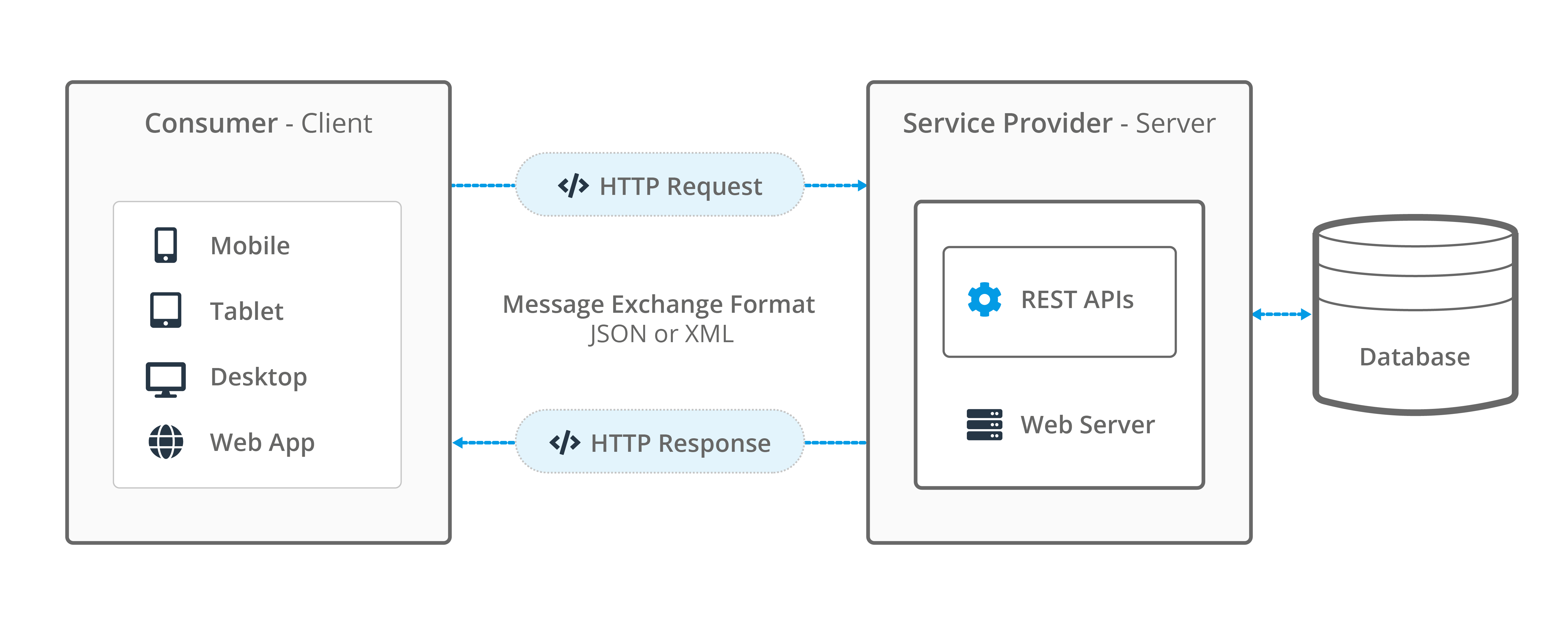

従来のREST APIは「即時応答」が前提でした。しかしLLMは平均数秒の応答時間を要します。そのため、

- HTTP長時間接続

- Server-Sent Events

- WebSocket

- ストリーミングレスポンス

が前提設計になります。

同期型フレームワークではスレッドがブロックされ、同時接続数が急激に低下します。AI導入後に「急に重くなる」原因はここです。

バックエンドの責務が変わった

- 従来

業務ロジック実装層

- AI時代

推論API制御層 + キュー制御 + キャッシュ管理

重い処理は外部推論サービスやPython層へ分離し、Web層はI/O最適化に集中する設計が主流になります。

2. AIネイティブ・アーキテクチャの具体要件

以下を満たさない場合、将来的に再設計が必要になります。

- async/awaitが第一級市民であること

- ストリーミングHTTPを自然に扱えること

- 型安全なAPI定義(OpenAPI自動生成含む)

- Docker/Kubernetes前提の軽量起動

- AI処理層とのサービス分離が容易

3. フレームワーク別・技術的深掘り評価

FastAPI

技術評価:AI API基盤として最短距離

強み

- ASGIベースで完全非同期

- Pydanticによる型安全

- OpenAPI自動生成

- Python AIライブラリと同一言語圏

実運用ポイント

- CPU負荷の高い推論はワーカー分離必須

- Gunicorn + Uvicorn構成が安定

適合度

LLM APIサーバー、社内AI基盤に最適

Django

技術評価:AI管理SaaS向き

強み

- 強力なORM

- 認証・管理画面の完成度

弱点

- asyncは後付け要素

- ストリーミング設計は工夫が必要

向いている用途

バックオフィス系AI、業務管理システム

NestJS

技術評価:エンタープライズAI基盤

強み

- TypeScript前提設計

- DIコンテナ構造

- マイクロサービス構成が自然

設計思想

AI層はPythonに分離し、BFF/統合層として活用するのが現実的。

Next.js

技術評価:AI UI統合の最適解

強み

- React Server Components

- ストリーミング描画

- Edge Runtime対応

重要ポイント

重い処理をNode側で抱えない設計が必須。API分離が前提。

4. AI統合パターン別の実装戦略

Chatbot(リアルタイム)

構成

FastAPI(推論API) + Next.js(UI)

設計要点

- SSEまたはWebSocket

- トークン単位ストリーミング

- レスポンスキャッシュ導入

Recommendation(推論 + バッチ)

構成

Djangoまたは NestJS + Python推論サービス

設計要点

- 行動ログ保存

- 定期再学習

- APIキャッシュ戦略

Automation(長時間処理)

構成

FastAPI + 非同期ワーカー

設計要点

- キュー管理

- 再試行制御

- タスク状態監視API

5. AIフレンドリー度ランキング(実装難易度込み)

Webフレームワークランキングを見る際は、「LLMを10万同時接続で回せるか」を基準に考えると本質が見えます。

6. 今後3年の技術進化予測

- API専用軽量フレームワークが主流化

- Python推論層とTypeScript統合層の分離が標準化

- エッジ環境での軽量推論が増加

- フレームワーク内部にAI SDK統合が進む

MVC中心設計は徐々に減少し、「AI統合レイヤー」が設計の中心になります。

AIはWeb開発の前提を根本から変えました。重要なのは表示速度や人気ではなく、非同期処理能力、ストリーミング耐性、AI層との分離設計です。FastAPIは推論基盤に最短距離で接続でき、Next.jsはAI UI統合に最適、NestJSは大規模構造設計に向いています。Webフレームワークランキングを参考にする際は、人気順ではなく「AIネイティブ設計かどうか」で評価することが、今後3年間で技術的負債を回避する最も現実的な判断基準になります。

ハトネット は、全国の IT 企業間の現場の IT 担当者を結び付け、雇用主が効果的かつ専門的な方法でリソースを最大限に活用し、コストを節約できるよう支援します。

IT 業界で最大 500,000 人の人々を接続します。

パートナーを見つけるコストを節約します。

小さなご要望でも、いつでもオンラインでお申し込みください。

※お問い合わせ:

メール: hello@hatonet.com

.jpg)